Yiğit, Gülsüm

Loading...

Profile URL

Name Variants

Y.,Gulsum

Gülsüm YIĞIT

Yiğit, GÜLSÜM

Gülsüm Yiğit

GÜLSÜM YIĞIT

G. Yiğit

Yiğit,G.

Y., Gülsüm

Yigit,Gulsum

YIĞIT, Gülsüm

Yiğit, Gülsüm

Gulsum, Yigit

Yiğit, G.

Yigit,G.

Y., Gulsum

YIĞIT, GÜLSÜM

Yigit, Gulsum

Gülsüm YIĞIT

Yiğit, GÜLSÜM

Gülsüm Yiğit

GÜLSÜM YIĞIT

G. Yiğit

Yiğit,G.

Y., Gülsüm

Yigit,Gulsum

YIĞIT, Gülsüm

Yiğit, Gülsüm

Gulsum, Yigit

Yiğit, G.

Yigit,G.

Y., Gulsum

YIĞIT, GÜLSÜM

Yigit, Gulsum

Job Title

Araş. Gör.

Email Address

Main Affiliation

Computer Engineering

Status

Current Staff

Website

ORCID ID

Scopus Author ID

Turkish CoHE Profile ID

Google Scholar ID

WoS Researcher ID

Sustainable Development Goals

15

LIFE ON LAND

0

Research Products

16

PEACE, JUSTICE AND STRONG INSTITUTIONS

0

Research Products

14

LIFE BELOW WATER

0

Research Products

6

CLEAN WATER AND SANITATION

0

Research Products

3

GOOD HEALTH AND WELL-BEING

1

Research Products

17

PARTNERSHIPS FOR THE GOALS

0

Research Products

4

QUALITY EDUCATION

0

Research Products

2

ZERO HUNGER

0

Research Products

10

REDUCED INEQUALITIES

0

Research Products

7

AFFORDABLE AND CLEAN ENERGY

0

Research Products

13

CLIMATE ACTION

0

Research Products

1

NO POVERTY

0

Research Products

9

INDUSTRY, INNOVATION AND INFRASTRUCTURE

0

Research Products

12

RESPONSIBLE CONSUMPTION AND PRODUCTION

0

Research Products

8

DECENT WORK AND ECONOMIC GROWTH

0

Research Products

11

SUSTAINABLE CITIES AND COMMUNITIES

0

Research Products

5

GENDER EQUALITY

0

Research Products

Documents

12

Citations

49

h-index

5

Documents

0

Citations

0

Scholarly Output

11

Articles

6

Views / Downloads

74/428

Supervised MSc Theses

0

Supervised PhD Theses

0

WoS Citation Count

13

Scopus Citation Count

44

WoS h-index

3

Scopus h-index

4

Patents

0

Projects

0

WoS Citations per Publication

1.18

Scopus Citations per Publication

4.00

Open Access Source

2

Supervised Theses

0

| Journal | Count |

|---|---|

| Knowledge and Information Systems | 2 |

| 2019 Innovations in Intelligent Systems and Applications Conference (ASYU) | 1 |

| 2021 International Conference on INnovations in Intelligent SysTems and Applications, INISTA 2021 - Proceedings | 1 |

| 2023 Innovations in Intelligent Systems and Applications Conference, ASYU 2023 -- 2023 Innovations in Intelligent Systems and Applications Conference, ASYU 2023 -- 11 October 2023 through 13 October 2023 -- Sivas -- 194153 | 1 |

| Bilişim Teknolojileri Dergisi | 1 |

Current Page: 1 / 2

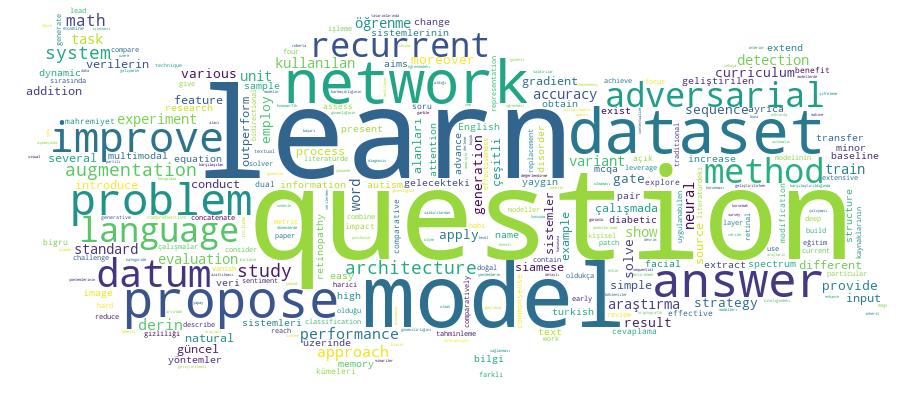

Competency Cloud